Buscan aumentar la bioseguridad ante la posibilidad de fabricar proteínas peligrosas con IA

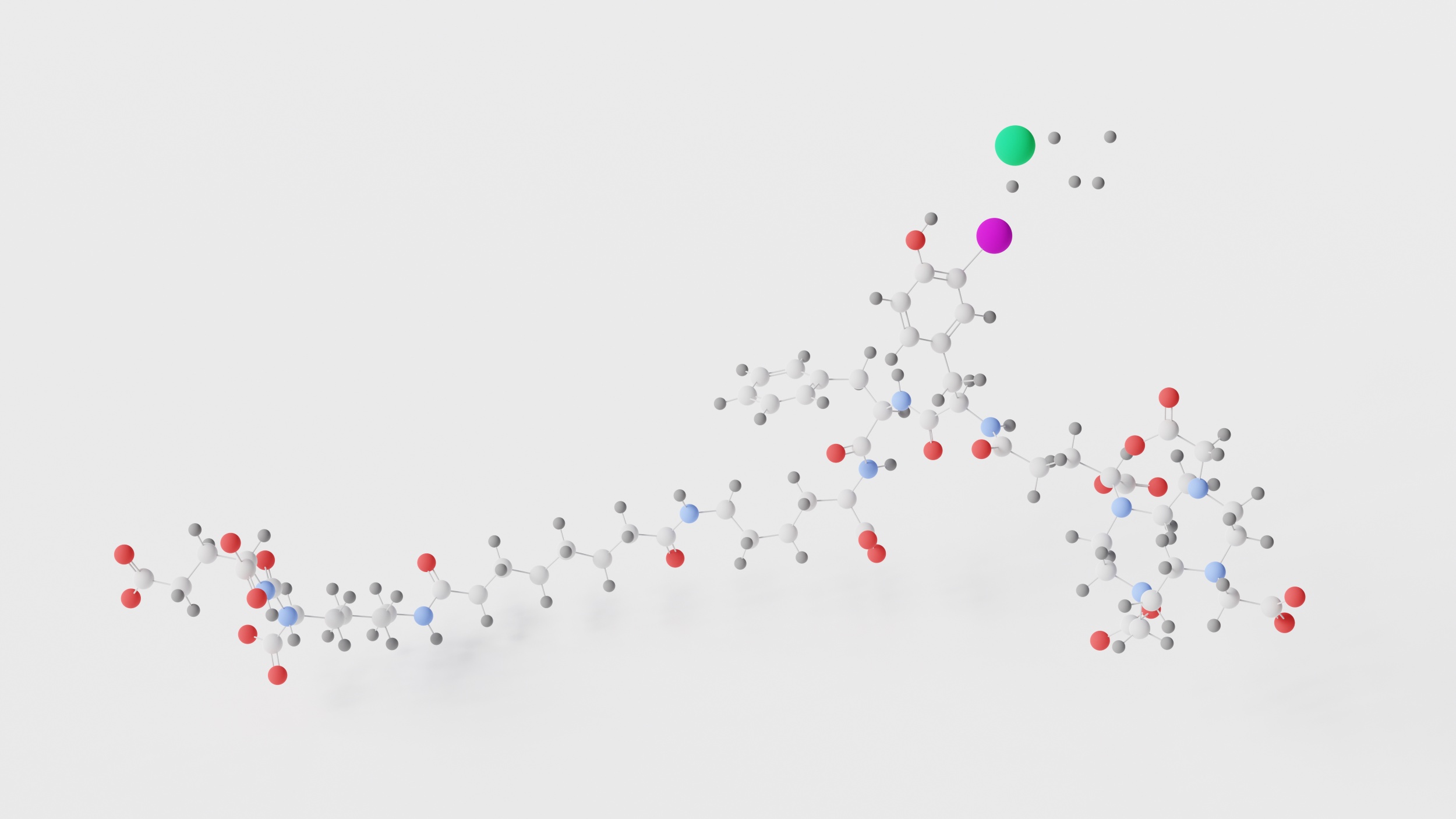

La ingeniería de proteínas asistida por inteligencia artificial (IA) está permitiendo avances en el diseño de nuevas moléculas, pero también plantea desafíos de bioseguridad relacionados con la posible producción de proteínas dañinas o peligrosas. Algunas de estas amenazas, deliberadas o accidentales, pueden no ser detectadas por las herramientas actuales de control. Un equipo internacional ha analizado la situación y ha desarrollado parches de software para mejorar su identificación, aunque reconocen que sigue siendo incompleta. Los autores del trabajo, que se publica en la revista Science, advierten que parte de los datos y el código no deben publicarse en un repositorio público debido a su posible uso indebido.

Valencia - Software bioseguridad

Alfonso Valencia

Profesor ICREA y director de Ciencias de la Vida en el Centro Nacional de Supercomputación de Barcelona (BSC)

Las tecnologías de IA generativa, como su nombre indica, están diseñadas para generar datos sintéticos. Variantes populares como ChatGPT producen textos artificiales que resultan indistinguibles de los reales. En otros campos, estas mismas herramientas se utilizan para crear genomas, proteínas, imágenes médicas y muchas otras aplicaciones de utilidad científica y médica. El problema, que resulta evidente en el caso de ChatGPT, es que en la mayoría de los casos carecemos de métodos para evaluar la calidad de esos datos sintéticos. ¿Podemos confiar en los textos que genera ChatGPT?

Esta limitación es intrínseca a la tecnología y bien podría no tener solución dentro del marco de este tipo de aproximaciones. Entonces, ¿qué podemos hacer? Una solución práctica, ya implementada en sistemas como ChatGPT, consiste utilizar grandes cantidades de datos (promts) lo más exhaustivos posibles que prueben su capacidad y consistencia, conocido como Red Teaming. Por ejemplo, se puede pedir a un sistema especializado en finanzas que responda preguntas sobre viajes. Si contesta, sabemos que está operando fuera de su ámbito y debe ser corregido. Lo mismo es cierto para evitar respuestas sesgadas por sexo y género, sometiendo a los sistemas a preguntas sistémicas con sus variantes sintácticas y semánticas para evaluar cuantas veces siguen dando respuestas inaceptables.

La reciente publicación aplica esta misma lógica en el ámbito de las proteínas potencialmente peligrosas. La capacidad de los sistemas de IA generativa (GenAI) para generar proteínas completamente nuevas, con secuencias y funciones distintas a las naturales, ha revolucionado la biotecnología y sus aplicaciones, incluyendo las biomédicas —como el diseño de nuevos anticuerpos—. De hecho, el Premio Nobel otorgado a David Baker en 2024 reconoció los avances logrados con estas herramientas en el diseño de proteínas. Se trata de un avance muy positivo, pero conlleva un riesgo: la posibilidad de generar proteínas peligrosas. Lo primero que viene a la mente es una variante más infecciosa del coronavirus. Hace un año, el propio David Baker, junto a George Church, un famoso biotecnólogo, ya advirtieron de los peligros asociados al diseño de proteínas con herramientas de GenAI.

Actualmente, este riesgo se gestiona mediante software de cribado de bioseguridad (BSS, por sus siglas en inglés), que predice la peligrosidad de nuevas proteínas cuando se solicita su generación (la síntesis del ADN necesario para producirlas). El artículo demuestra, en primer lugar, que, cuando se enfrenta a numerosas variantes nuevas (Red Teaming, equivalente a preguntar sobre viajes a un sistema financiero), los cuatro programas más utilizados fallan y lo hacen más cuanto más se alejan las secuencias de las naturales. Ante estos resultados, los autores proponen una serie de mejoras de software que, aunque efectivas en los casos probados, no resuelven el problema por completo ni de modo general.

Un aspecto interesante de esta publicación es que, de acuerdo con la revista, los autores no han hecho público su software abiertamente, para evitar que otros puedan desarrollar contramedidas y eludir las restricciones. Esto es una prueba más de la debilidad de este tipo de aproximaciones y de la enorme dificultad que existe para controlar las propiedades de los datos sintéticos producidos por los métodos de GenAI.

- Artículo de investigación

- Revisado por pares

Wittmann et al.

- Artículo de investigación

- Revisado por pares