La lectura de un paper es una tarea diaria del periodismo científico. No es sencillo, ya que es necesario conocer su estructura y tener presente que existen diferentes tipos de estudios. Además, hay que aprender a analizar sus números. Antes de empezar, una buena noticia: no es necesario ser matemático ni haber estudiado estadística para tener ciertas nociones que ayuden a entender un estudio y, sobre todo, detectar sus limitaciones y posibles errores.

1. ¿Qué es lo que pregunta este estudio?

Todo paper intenta responder a una o más preguntas. Entender esto es importante porque los análisis estadísticos irán destinados a contestarla. Es esta pregunta, y no otra, la que el estudio permite (¡en el mejor de los casos!) contestar con más o menos seguridad.

Por ejemplo, si un estudio analiza si la medida de obligar a los niños a llevar mascarilla en clase sirvió para reducir la transmisión de la covid-19, no podrá contestar otras preguntas más allá de la efectividad de esa política. Sus resultados no permitirán concluir si las mascarillas funcionan desde el punto de vista de la física, qué tipo de mascarilla es mejor, si la obligación funcionó en otras edades o contextos o si los más pequeños las usan correctamente.

2. ¿Alguien sabe lo que es el p-valor?

Se trata de un concepto difícil de explicar y entender, a pesar de su omnipresencia en la literatura científica. El p-valor se define como la probabilidad de que el efecto observado sea debido solo a la casualidad. Por ejemplo, que las diferencias observadas en la mortalidad de un grupo de pacientes que recibió un fármaco y otro que recibió un placebo sean pura coincidencia.

Si este valor es mayor que 0,05 se considera que es “probable” que el efecto observado sea debido a la casualidad, por lo que el resultado se considera “estadísticamente no significativo”. En caso contrario, si el p-valor es menor que 0,05, se considera que es “probable” que el efecto observado no sea debido a la casualidad y el resultado se considera “estadísticamente significativo”.

Más importante que entender el p-valor es saber qué no significa: no significa que las conclusiones del estudio sean ciertas ni que los resultados sean correctos. Un estudio puede estar repleto de p-valores bajos y aun así estar completamente equivocado si no se han tenido en cuenta otros factores como los factores de confusión.

3. Intervalos de confianza

Los valores obtenidos por un estudio —por ejemplo, que una vacuna tiene una eficacia del 60 %— no son una verdad absoluta, sino una aproximación estadística a la verdad. Como toda aproximación, existe un margen de error inevitable. Esto es lo que se conoce como intervalo de confianza, que se define como el rango de valores posibles alrededor del valor observado que contendrán el valor real en el 95 % de las ocasiones.

Conocer este intervalo es muy importante para evaluar la calidad del resultado. No es lo mismo que una vacuna tenga una eficacia del 60 % (30 % - 91 %) que una eficacia del 60 % (58 % - 62 %). En el primer caso la incertidumbre es mayor y cabe la posibilidad de que la vacuna sea mucho más o mucho menos efectiva.

4. Cuidado con los subgrupos

El tamaño de la muestra que utiliza un estudio nunca es garantía de su calidad, pero es cierto que puede ayudar a lograr cierta robustez estadística. Es por eso que los fármacos empiezan probándose en unos pocos seres humanos, pero terminan por estudiarse en grandes análisis clínicos con miles de personas.

Sin embargo, en ocasiones un estudio puede intentar encontrar relaciones no muy evidentes buceando entre los subgrupos de la muestra. Este zoom puede detectar asociaciones interesantes, pero también aumenta el riesgo de que se encuentren artefactos estadísticos conforme el tamaño de la muestra disminuye. Así, un fármaco contra el dolor de cabeza que no ha mostrado efectividad en 10.000 pacientes podría hacerlo si miramos solo a hombres caucásicos de entre 18 y 36 años, sin que esto necesariamente implique que funciona.

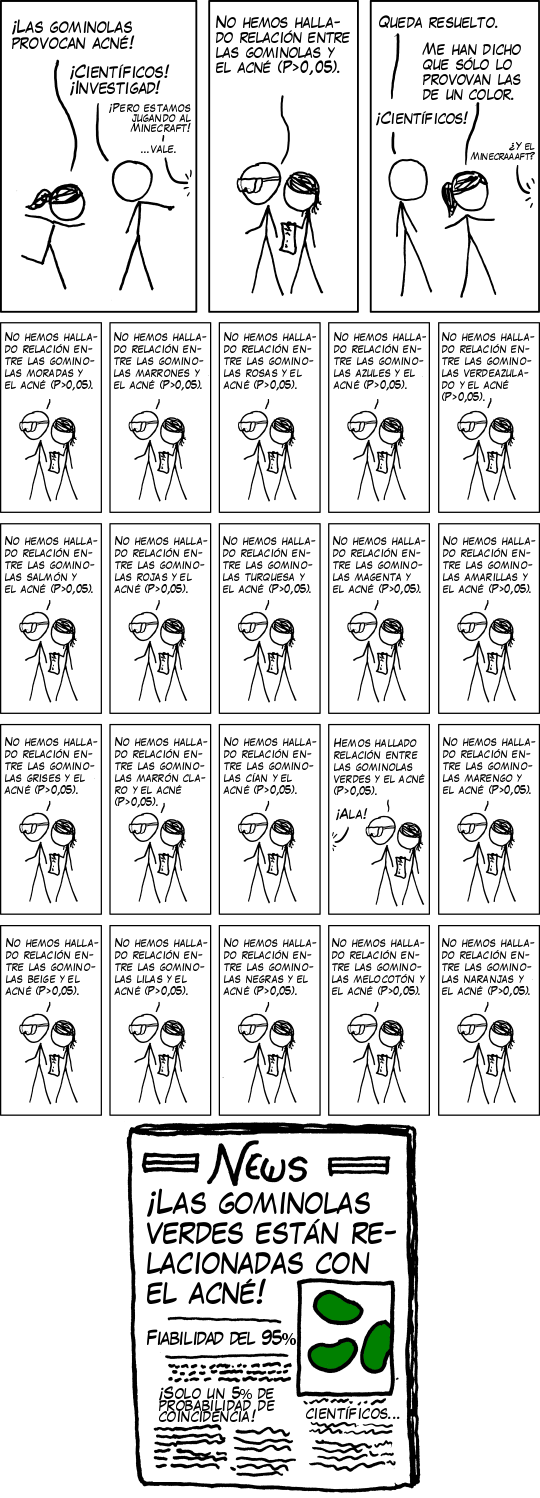

Esto es un ejemplo de lo que se denomina “torturar los datos”, un problema que resume la siguiente viñeta de xkcd traducida a castellano:

5. ¿Es la muestra aleatoria?

La aleatoriedad es una de las partes más importantes de un estudio. Cuando no se logra, se cae en el llamado sesgo de selección, que puede distorsionar los resultados. Obtener una muestra aleatoria es un reto para el diseño de un estudio y no siempre es fácil.

Por ejemplo, si queremos saber qué porcentaje de los españoles son seguidores del Real Madrid no obtendremos los mismos resultados si hacemos una encuesta telefónica en todo el país que si la hacemos en una peña madridista de la capital.

6. Riesgos relativos y absolutos

“Tomar ibuprofeno aumenta el riesgo de infarto un 50 %”. “Las personas que han pasado la covid-19 tienen un 60 % más de probabilidades de ser diagnosticadas con alzhéimer”. Es común leer este tipo de titulares en los medios, cuyos porcentajes pueden ser causa de alarma. La pregunta es: ¿un 50 o un 60 % más de probabilidades respecto a qué?

Estos porcentajes son altos porque hacen referencia al riesgo relativo, pero no dicen mucho si no sabemos el riesgo absoluto: un riesgo bajo seguirá siéndolo, aunque aumente mucho. Por ejemplo, no es lo mismo si un fármaco reduce el riesgo de muerte del 20 al 10 % que si lo hace del 0,2 al 0,1 %. Aun así, en ambos casos se ha reducido el riesgo relativo un 50 %.

Tener esto presente a la hora de comunicar es importante para evitar dar el mensaje de que un fármaco es más efectivo o peligroso de lo que realmente es. Puedes leer más sobre este tema en nuestro recurso sobre comunicación de riesgos.

7. Cuidado con asumir causalidad: el peligro de los estudios observacionales y los factores de confusión

Imaginemos que realizamos un estudio con miles de personas a las que preguntamos si la noche anterior durmieron con los zapatos puestos y si se han levantado a la mañana siguiente con dolor de cabeza. Los resultados muestran inequívocamente que la gente que se duerme sin quitarse los zapatos tiende a despertarse con cefalea.

Sería atractivo concluir que meterse en la cama con zapatos provoca dolor de cabeza. Sin embargo, podría ser que los autores del estudio hubieran olvidado un factor de confusión responsable de la cefalea: que la gente que ha bebido mucho alcohol tiende más a meterse en la cama vestida y con los zapatos.

El ejemplo está extraído del podcast Inaplicables, en el que se analiza la dificultad que supone concluir causalidad en ciencia, por muy atractivo que resulte. “Correlación no implica casualidad” es una frase que ya se repite de forma acrítica, pero que resulta imprescindible tener presente.

Los estudios observacionales —como el del ejemplo inventado de los zapatos y la resaca— son aquellos en los que el investigador no manipula factor alguno, sino que se limita a medir las variables de interés en diferentes poblaciones o individuos. Son muy comunes porque resultan más fáciles de realizar, pero tienen la limitación de que no permiten extraer causalidad.

8. A veces no hace falta penetrar en la caja negra

El biólogo de la Universidad de Washington Carl Bergstrom compara la estadística de un estudio con una caja negra cuyo interior no podemos dilucidar en su libro Bullshit: contra la charlatanería. Antes de cegarnos con intervalos de confianza, p-valores y tablas ANCOVA puede ser una buena idea leer los resultados con algo de escepticismo y sentido común.

“Por lo general, no tenemos que abrir la caja negra para poder tildar de bullshit las afirmaciones que esta genera”, asegura Bergstrom. Se trata de un consejo especialmente útil cuando nos enfrentamos a un estudio que realiza afirmaciones extraordinarias.

Por ejemplo, no hace falta tener un doctorado en estadística ni revisar a mano los cálculos para sospechar que un estudio que asegura que el consumo de repollo está asociado con una menor mortalidad por covid-19 no puede demostrar la causalidad entre ambos fenómenos.