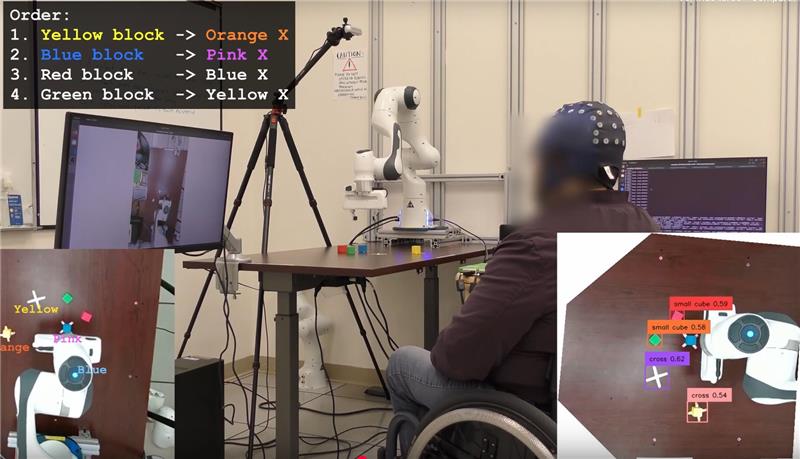

Organizan la primera conferencia científica con sistemas de IA como autores y revisores

Un grupo de investigación de la Universidad Stanford (Estados Unidos) ha organizado la primera conferencia académica en la que herramientas de inteligencia artificial (IA) sirven tanto de autores como de revisores de artículos científicos. Llamada Agents4Science 2025, la conferencia tendrá lugar el 22 de octubre.