Proponen un sistema híbrido de detección visual para vehículos autónomos

Combinar dos tipos de cámaras permitiría a los vehículos autónomos detectar objetos con precisión y eficacia, según afirma un equipo de investigadores de Suiza en un estudio publicado en Nature. Los vehículos autónomos necesitan sistemas visuales capaces de detectar objetos que se mueven con rapidez sin sacrificar la calidad de las imágenes. El sistema descrito combina una cámara de color con una frecuencia de imagen reducida –para bajar el ancho de banda necesario para procesar imágenes— y una cámara de eventos, que detecta movimientos rápidos –como los de peatones o vehículos– y compensa la mayor latencia de la cámara de color.

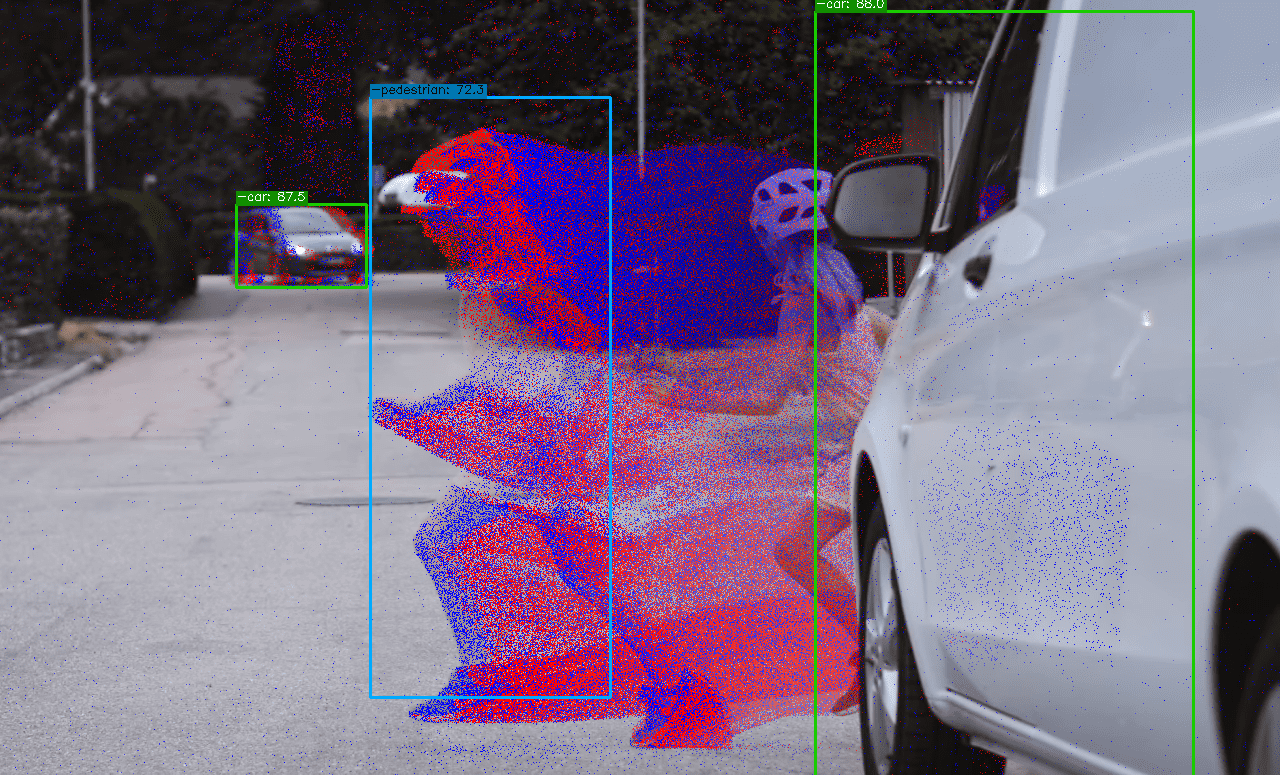

La imagen muestra tanto la información de color de la cámara en color como los eventos (puntos azules y rojos) de la cámara de eventos generados por un peatón corriendo. Crédito: Robotics and Perception Group, Universidad de Zúrich, Suiza.

Angélica Reyes - cámara coche autónomo

Angélica Reyes

Profesora del departamento de Arquitectura de Computadores de la Universidad Politécnica de Cataluña e investigadora del grupo de Comunicaciones Inteligentes y Aviónica para Sistemas Aéreos No Tripulados Robustos

El desarrollo de sistemas de transporte inteligente está orientado a ofrecer servicios de información de tráfico en tiempo real a todos los usuarios de la vía, desde vehículos autónomos, peatones, hasta los usuarios más vulnerables, como pueden ser las personas con alguna discapacidad. En un ecosistema en que los vehículos se comunicarán con otros vehículos y con diferentes infraestructuras de la vía, se vuelve trascendental que los vehículos sean capaces de analizar y procesar la información recibida para tomar decisiones. Sin embargo, características como las altas velocidades de los vehículos, la movilidad constante, la variable densidad del tráfico, etc., plantean grandes desafíos.

El artículo de Daniel Gehrig y Davide Scaramuzza presenta un avance interesante en la visión para automóviles utilizando cámaras de eventos combinadas con cámaras RGB que mejoran la percepción en tiempo real con una alta resolución y baja latencia, lo cual es crucial para la detección rápida y precisa de objetos en condiciones de alta velocidad y cambios abruptos de iluminación. Los autores utilizan una red neuronal convolucional (CNN) para procesar imágenes y una red neuronal de grafos asincrónica (GNN) para procesar eventos.

- Artículo de investigación

- Revisado por pares

Daniel Gehrig & Davide Scaramuzza.

- Artículo de investigación

- Revisado por pares