Reacciones: acuerdo de las instituciones europeas sobre la ley de inteligencia artificial

Después de largas negociaciones, la Comisión Europea, el Parlamento Europeo y el Consejo de la UE ―que representa a los Estados miembros― llegaban la pasada madrugada a un acuerdo provisional sobre el contenido de la ‘AI Act’, la futura ley que regulará el desarrollo de la inteligencia artificial en Europa, la primera en todo el mundo. El acuerdo limita el uso de los sistemas de identificación biométrica por las fuerzas de seguridad, recoge normas para modelos de IA generativa como ChatGPT y contempla multas que pueden llegar a los 35 millones de euros a quien vulnere las normas, entre otras medidas. El texto ahora deberá ser adoptado formalmente por el Parlamento y el Consejo antes de convertirse en legislación de la UE.

Alfonso Valencia - ley IA

Alfonso Valencia

Profesor ICREA y director de Ciencias de la Vida en el Centro Nacional de Supercomputación de Barcelona (BSC)

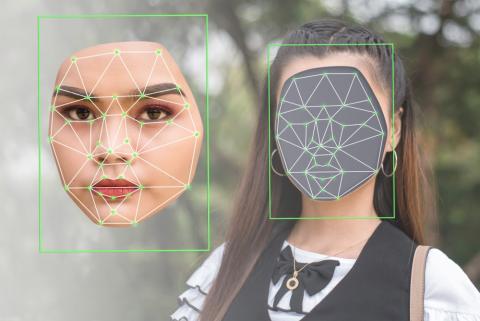

La propuesta legislativa acordada afecta principalmente a dos tipos de aplicaciones: las de reconocimiento de personas (reconocimiento facial, biometría, etc.), que se prohíben con excepciones, y las denominadas de ‘alto riesgo’, como son los modelos generales (el popular ChatGPT, entre otros).

Respecto a las aplicaciones de técnicas de reconocimiento biométrico se hacen excepciones para temas policiales que hacen difícil saber dónde acabará el uso de estas tecnologías en la práctica.

En cuanto a la segunda categoría de grandes modelos generales (modelos fundacionales) que, entrenados con grandes cantidades de texto reproducen características de utilidad práctica cada vez más avanzadas (del ChatGPT a GPT4), el documento propone medidas restrictivas que requieren valoración de riesgos, descripción detallada de su funcionamiento o describir todas las fuentes de datos usadas para su entrenamiento. Medidas que son relativamente fáciles de aplicar a sistemas tradicionales como los que operan en bancos o compañías de seguros, pero muy difíciles o imposibles en los nuevos sistemas de IA.

La ampliación de estas medidas implicará que los sistemas actuales de las grandes compañías no podrán operar en Europa, salvo a través de IPs de fuera de Europa (un floreciente negocio). En este contexto será muy difícil para Europa, donde operan grupos de investigación, pymes y compañías mucho más pequeñas que las americanas, desarrollar sistemas competitivos. Conscientes del daño que estas medidas pueden producir tanto a las compañías desarrolladoras de sistemas como a las que los usan, el propio texto habla de entornos en los que las compañías puedan desarrollar esos sistemas “seguros” que deja en manos de los gobiernos. Dado que no existe ni la iniciativa, ni el presupuesto, ni la unidad de acción, ni la tecnología para crear esos sistemas, parece que la aplicación de las medidas propuestas dejará definitivamente a Europa fuera del desarrollo de los grandes modelos de IA.

Un asunto no menor contenido en esta propuesta es la repetición de la necesidad de que los modelos se adhieran a leyes de propiedad intelectual. Entrenar modelos fundacionales requiere la utilización de información masiva equivalente básicamente al contenido de internet. En esta enorme cantidad de datos es imposible detectar de modo automático el nivel de copyright y aún más pagar por la utilización de cada texto. Esta limitación por sí sola es suficiente para acabar con el desarrollo de estos grandes modelos en Europa. La alternativa existe y es razonable, si consideramos que los modelos no son más que sistemas estadísticos que no reproducen los textos específicos, solo generan características estadísticas conjuntas de toda la información. Por tanto, parecería razonable buscar medidas generales que compensen por el uso de la información en vez de aplicar masivamente las leyes de copyright.

En resumen, Europa se limita mucho en el uso y desarrollo de grandes modelos, sin ofrecer alternativas técnica y económicamente viables.

Paloma Llaneza - ley IA

Paloma Llaneza

Abogada, auditora de sistemas, consultora de seguridad experta en los aspectos legales y regulatorios de internet y CEO de Razona Legaltech, consultora tecnológica experta en identidad digital

¿Qué cambios más importantes podrían afectar a las empresas y a la investigación?

“Creo que el principal impacto es que van a tener que limitar el uso de la IA en los sistemas de toma de decisiones basados en datos personales que incluyen los perfilados por comportamiento o emoción, así como la incorporación de un análisis de riesgos previo a poner en producción determinados modelos en atención a su criticidad”.

¿Qué podría cambiar para los usuarios?

“Visto desde el lado del usuario, se debería limitar el uso de sus datos para el perfilado a través de sistemas de IA o algoritmos orientados a modelos de éxitos que carecen de transparencia y explicabilidad. De hecho, el acuerdo político sobre la IA Act coincide con una sentencia del Tribunal de Justicia de la UE que declara ilícito el sistema de scoring de crédito alemán usado por la banca y entidades de crédito por tratarse de un sistema completamente automatizado que incumple el RGPD”.

La Unión Europea se quiere posicionar como líder para guiar el desarrollo de la IA en el mundo. ¿Son realistas estas ambiciones? ¿Cómo ayudará esta ley a cumplirlas?

“Europa lleva años queriendo posicionarse como referente moral de la tecnología poniendo al ser humano en el centro a través de la aprobación de varias normas como el RGPD, DSA o DMA, pero olvida los problemas de regular y sancionar a empresas que operan desde fuera de la UE. Es cierto que el Reglamento prevé un sistema de sanciones pero, en el día a día, los usuarios se encuentran bastante perdidos en cuanto a infracciones personales y concretas.

Debemos plantearnos si la mejor manera de proteger la democracia es sancionar empresas que incluyen en su análisis de riesgos operativos las sanciones posibles y deciden que les compensan, o potenciar el desarrollo de herramientas competitivas en Europa que cumplan nuestros estándares regulatorios. Mientras esto no ocurra, seremos una colonia de EEUU que acabará arrasando nuestra regulación o integrándola, como digo, como otro coste más.

Por lo demás, los riesgos de las IAs fundacionales, que son enormes por su penetración y potencia, no se han solventado en esta regulación”.

La IA se desarrolla muy rápido, mientras que el trabajo legislativo es más lento. ¿Esta ley podrá tener un impacto rápido y duradero?

“Ningún reglamento funciona ya sin actos de implantación y estandarización técnica. Es en esos detalles donde está el diablo de cualquier regulación y donde hay que dar la batalla.

En todo caso, el reglamento regula realidades que ya hoy están obsoletas o se podían gestionar con regulación ya aprobada. Está pensada para desarrollos empresariales o estatales, pero deja escapar la IA generativa de consumo que es, en realidad, el gran reto que tenemos por delante”.

Claudio Novelli - ley IA

Claudio Novelli

Investigador posdoctoral del departamento de Estudios Jurídicos de la Universidad de Bolonia (Italia) e international fellow del Digital Ethics Center de la Universidad de Yale (EEUU)

Observar la negociación sobre la propuesta de la Ley de IA fue como asistir a la construcción de un puente sobre un vasto abismo de incertidumbre y posibles escollos. El compromiso fue clave para llegar a un acuerdo, aunque algunas decisiones fueron más difíciles que otras. Abandonar la autorregulación de los modelos de IA y optar por la supervisión directa fue un paso necesario. Prohibir la mayoría de los sistemas biométricos fue una medida prudente. Las fuerzas de seguridad pueden seguir utilizándolos en situaciones específicas, como la prevención del terrorismo o la explotación sexual, pero solo bajo control judicial y escrutinio independiente.

Pero esto es solo el principio. Aún quedan muchos detalles por concretar, como el papel de la Oficina de Inteligencia Artificial y su colaboración con las autoridades nacionales. Otro paso crucial es determinar cómo evaluarán quienes implementen la ley el impacto de sus sistemas de IA en los derechos fundamentales. Los próximos 24 meses serán cruciales. Determinarán si la UE ha alcanzado realmente su objetivo de liderar la regulación de la IA, estableciendo una referencia mundial para una gobernanza responsable e innovadora de esta.

Lucía Ortiz - ley IA

Lucía Ortiz de Zárate

Investigadora predoctoral en Ética y Gobernanza de la Inteligencia Artificial en el departamento de Ciencia Política y Relaciones Internacionales de la Universidad Autónoma de Madrid

El haber llegado a un acuerdo sobre la regulación de la Inteligencia Artificial (IA) es una buena noticia para todas y todos los europeos y europeas y, esperemos, que sea una llamada de atención al resto de países y potencias para que cunda el ejemplo y regulen estas tecnologías emergentes. La IA es un grupo de tecnologías de naturaleza transversal que puede aplicarse a ámbitos de muy diversa índole, desde el ocio hasta el control de fronteras, pasando por los procesos de selección de personal en empresas o estudiantes en la universidad. Es decir, cuando hablamos de IA tenemos que pensar desde chatbots que nos asisten cuando necesitamos información hasta sistemas de reconocimiento facial usados para identificar personas.

La regulación europea lo que pretende es crear un espacio en el que la adopción de estas tecnologías sea compatible con los valores y derechos fundamentales, ya que la IA puede generar grandes problemas relacionados con la privacidad de los datos, la transparencia, la rendición de cuentas o incluso puede generar situaciones discriminatorias. Tenemos ejemplos de otros países del mundo como, por ejemplo, China donde se recopilan datos de forma masiva para premiar o sancionar ciudadanos en función de su buen o mal comportamiento. La UE pretende evitar estos usos de la IA a través de una regulación basada en el riesgo que plantea requisitos muy estrictos para el uso de IA aplicada a ámbitos de alto riesgo como, por ejemplo, el control de fronteras, los procesos de selección de personal, etc.

Algunos riesgos los considera inaceptables, por ser contrarios a los valores y derechos fundamentales, y por ello estarán prohibidos en la UE. Así es el caso de los sistemas de puntuación social como el del caso chino, el uso de IA para modificar el comportamiento de las personas o explotar las vulnerabilidades de las personas (situación económica, edad, etc.). El uso de sistemas de sistemas de reconocimiento facial en tiempo real, que es muy polémico, parece que estará prohibido con algunas excepciones (terrorismo, secuestro, tráfico de personas, etc.).

Si la ley es efectiva lo veremos con el paso del tiempo. En principio, la regulación debería ser lo suficientemente flexible para adaptarse a los nuevos avances tecnológicos que cada vez se dan más rápido y, al mismo tiempo, lo suficientemente concreta para poder evitar situaciones que pueden ser muy graves y sancionar cuando sea necesario. En cualquier caso, es una buena noticia que la UE haya apostado por regular la IA y poner algunos límites a unas tecnologías que, sin control, podrían ser terriblemente dañinas, incluso sin nosotros ser conscientes de ello.